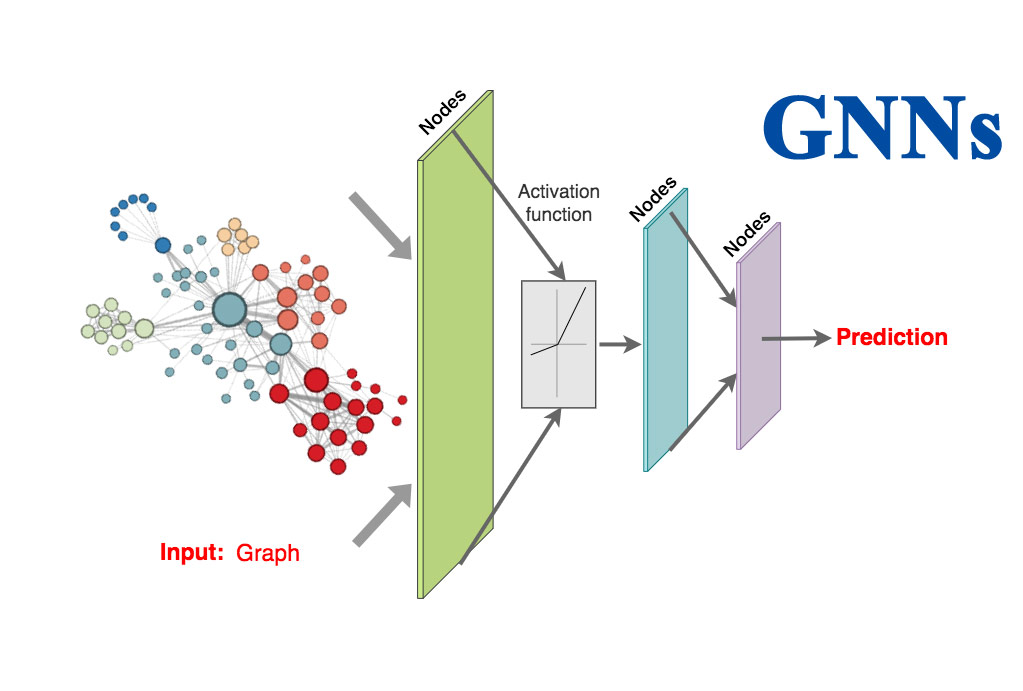

Por la capacidad de Graph Neural Networks (GNNs) en analizar datos en forma de grafos (“graphs”) y en realizar predicciones tan acertadas, estas redes neuronales vienen siendo aplicadas en diversas áreas con aún mejores resultados que otras técnicas utilizadas. Y por otro lado, sigue existiendo un creciente interés por parte de la comunidad científica en profundizar aún más las investigaciones en GNNs.

© 2022 by Sistemas.Ai

Por Homer Díaz

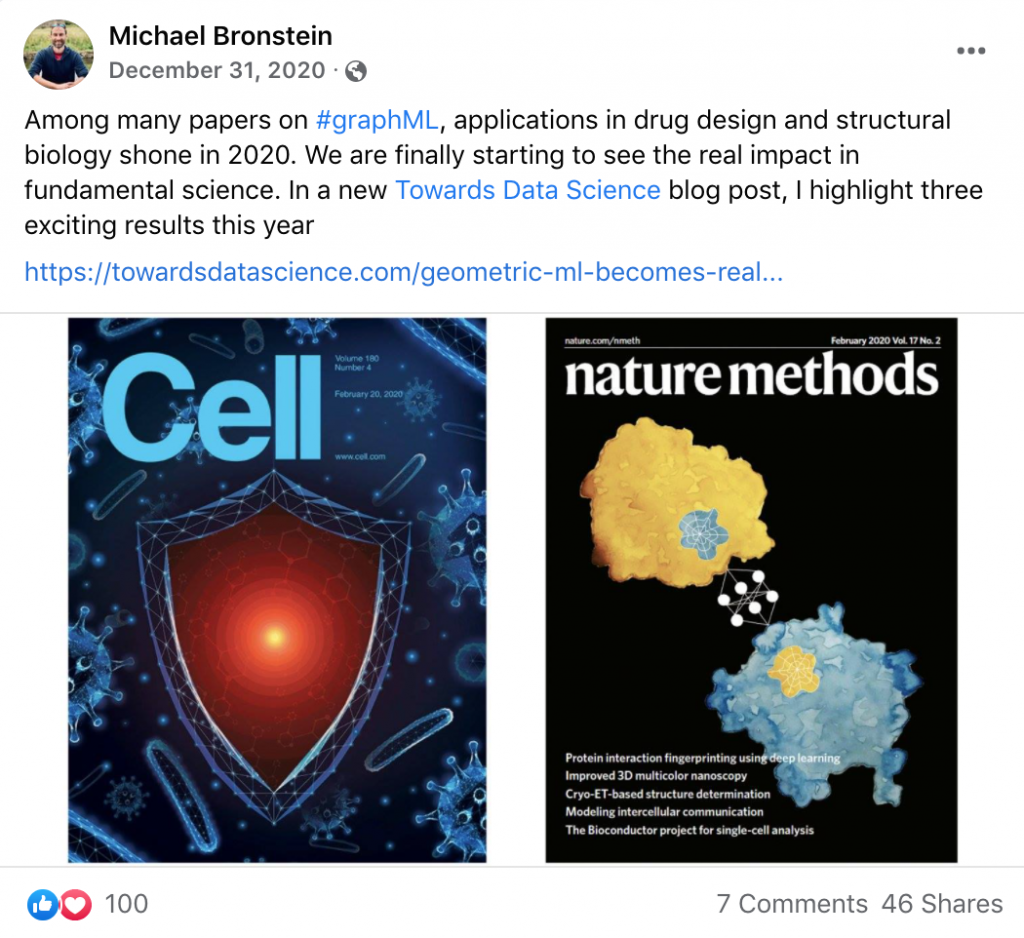

En el 2020 dos de las más importantes revistas científicas destacaron algunos trabajos científicos (“research papers”) acerca del uso de Geometric Deep Learning -esta expresión también se usa para referirse a GNNs. Uno de esos “research papers” trata acerca del descubrimiento de antibióticos muy potentes gracias al uso de Geometric Deep Learning: “A Deep Learning Approach to Antibiotic Discovery”, el cual fue destacado en portada por la revista Cell. Otra de las revistas que publicaron acerca del mismo descubrimiento fue Nature: “Powerful Antibiotics Discovered using Artificial Intelligence”.

En el siguiente “post”, Michael Bronstein (catedrático de inteligencia artificial en la Universidad de Oxford) muestra las revistas Cell y Nature Methods en cuyas portadas se destacaron los logros en el área de biología estructural y en el diseño de fármacos que se han alcanzado gracias a Graph Machine Learning (esta expresión también se usa para referirse a Geometric Deep Learning).

Este tipo de redes neuronales artificiales denominadas Graph Neural Networks (GNNs) también vienen siendo aplicadas en muchas otras áreas como por ejemplo en modernos sistemas de recomendación y en sistemas de navegación vial.

- Pinterest fue uno de los primeros en implementar GNNs en su sistema de recomendación a gran escala. En el “paper” y en el blog que llevan el mismo título “PinSage: A New Graph Convolutional Neural Network for Web-Scale Recommender Systems” puedes encontrar más detalles de la red neuronal que desarrollaron para tal fin a la cual denominaron PinSage.

- Uber Eats es otra de las compañías que ha puesto en práctica GNNs. En el blog “Food Discovery with Uber Eats: Using Graph Learning to Power Recommendations”, se detalla cómo integraron su sistema de recomendación con dicha tecnología.

- Google Maps es otro buen ejemplo del uso de GNNs para resolver problemas cotidianos a los que se enfrentan millones de usuarios. En el blog “Traffic Prediction with Advanced Graph Neural Networks”, se detalla cómo los científicos de DeepMind y Google lograron, gracias a GNNs, estimar con mucha mayor precisión los tiempos estimados de arribo en el App Google Maps.

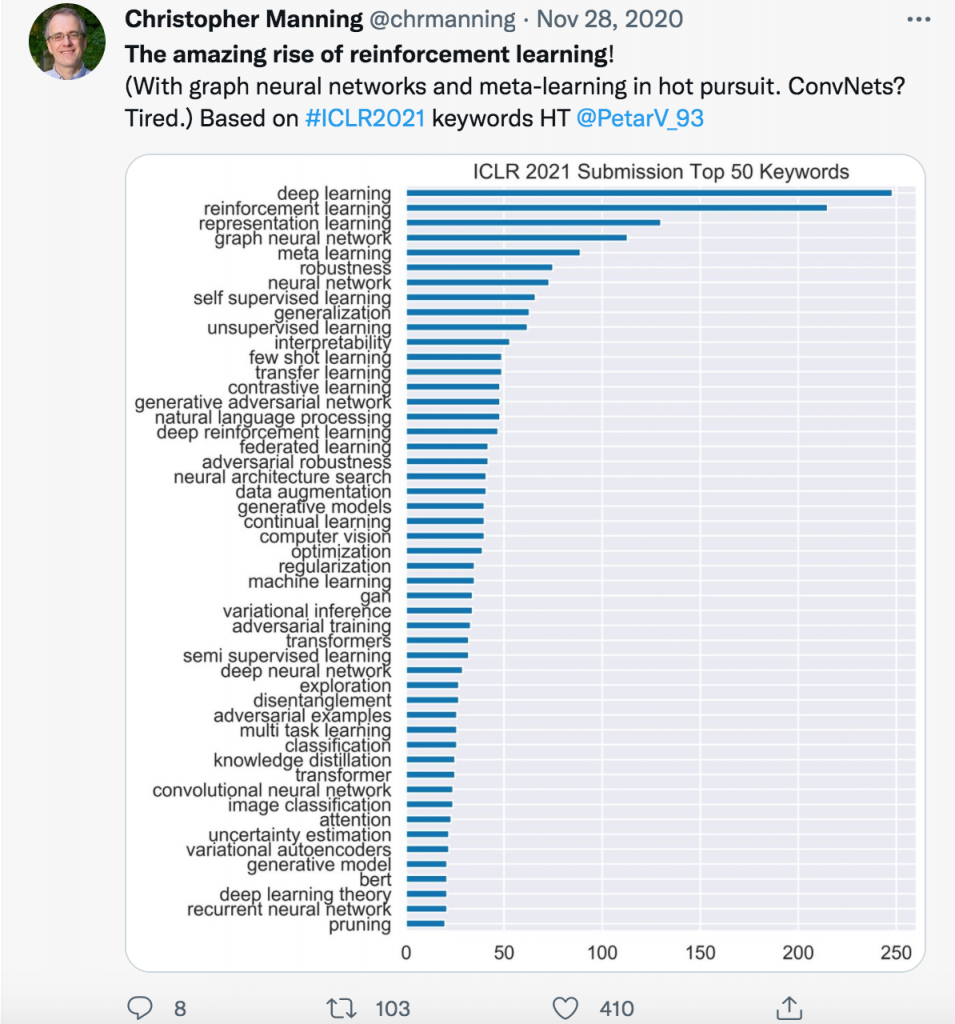

Por otro lado, GNNs han estado experimentado un creciente interés por parte de la comunidad científica en los últimos años. Cientos de trabajos de investigación científica (“research papers”) con temas relacionados a GNNs, están constantemente inundando las principales conferencias de inteligencia artificial como NeurIPS, ICLR, entre otras conferencias.

En el siguiente tweet se observa el TOP 50 de los términos más comunes (keywords) que se han encontrado en todos los “papers” de la conferencia: “The International Conference on Learning Representations 2021” (ICLR 2021). Christopher Manning, catedrático de la Universidad de Stanford y Director de Stanford AI Lab, destaca el sorprendente salto dado por Reinforcement Learning y el creciente interés en temas como Graph Neural Networks y Meta Learning.

Para tener una mejor idea del concepto de Graph Neural Networks o Geometric Deep Learning (sub-área de “Deep Learning”), primero es necesario explicar a grandes rasgos qué es Deep Learning, también conocido como Artificial Neural Networks (redes neuronales artificiales).

Casi todo lo que se escucha hoy en día acerca de inteligencia artificial es principalmente gracias a Deep Learning. Deep Learning es uno de los algoritmos de Machine Learning que permite que las computadoras aprendan y luego simulen nuestra capacidad de ver, escuchar y hasta cierto punto de razonar. Este algoritmo ha demostrado excelentes resultados especialmente procesando conjunto de datos como imagen, audio y texto.

En el artículo científico titulado “Deep Learning“, Yann LeCun, Yoshua Bengio y Geoffrey Hinton subrayan al inicio lo siguiente:

“Deep learning allows computational models that are composed of multiple processing layers to learn representations of data with multiple levels of abstraction. These methods have dramatically improved the state-of-the-art in speech recognition, visual object recognition, object detection and many other domains such as drug discovery and genomics“.

Lo anterior quiere decir que Deep Learning tiene como propósito el aprendizaje de las características (“to learn representations“) de la data que ingresa a una red neuronal artificial; en otras palabras, “Deep Learning” tiene como propósito extraer o diseñar automáticamente (sin intervención humana) las características del conjunto de datos que ingresan a un modelo neuronal que está compuesto de muchas capas. Estas características luego son usadas para realizar una infinidad de tareas como por ejemplo: reconocer visualmente objetos en imágenes y videos, traducir texto, transcribir lenguaje oral, etc.

Cuando nos referimos a características, nos referimos al tamaño, color, morfología de una célula, bordes y regiones que observamos por ejemplo en una imagen digitalizada de una célula.

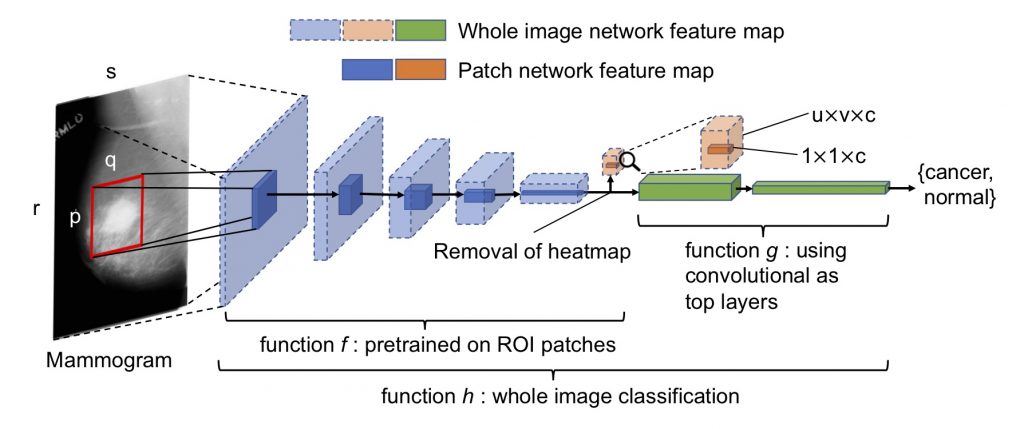

Para tener una idea más clara del concepto de “Deep Learning”, veamos la siguiente figura en la cual se observa una imagen digitalizada de una mamografía con aparentes signos de tumor. Esta mamografía ingresa a la red neuronal y atraviesa varias capas de izquierda a derecha con la finalidad de que la red detecte la presencia de tumor cancerígeno o no.

Para darles una idea de la magnitud del ingreso de los datos, supongamos que la imagen tiene un tamaño de 500×500 píxeles, por lo tanto la imagen de mamografía ingresa a la red descompuesta en 250,000 píxeles. Ya que estos modelos solo aceptan números, a un píxel se le representa por un número entre 0 y 255; es decir al modelo neuronal ingresan 250,000 números como datos de entrada.

Gracias a un proceso previo de entrenamiento de la red neuronal donde automáticamente se obtienen las características que presentan los tumores de mama, esta red neuronal es capaz de reconocer la existencia o no de un tumor canceroso y arrojar como resultado o bien “cáncer” o bien “normal” tal como se muestra en la siguiente figura obtenida del artículo científico titulado “Deep Learning to Improve Breast Cancer Detection on Screening Mammography“.

El diseño o representación (representación matemática) apropiada de las características que realmente capturen la estructura de la data juega un papel clave en los modelos de Deep Learning. Existen dos maneras de diseñar o extraer las características que representen la data: “feature engineering” y “representation learning“.

Cuando se realiza “feature engineering“, un profesional experto es quien diseña las características. Este proceso consume demasiado tiempo y muy menudo las características diseñadas -que sirven de entrada al sistema- no son las más apropiadas; y esto conlleva a que el modelo no sea del todo óptimo. Mientras que en “representation learning“, el diseño de las características se realiza de forma automática durante un proceso de entrenamiento de la red neuronal artificial.

Una red neuronal es en esencia una función matemática muy compleja la cual se optimiza mediante un proceso de entrenamiento o ajuste de dicha función. En esta etapa de entrenamiento, ingresan a la red un número determinado de datos -por ejemplo digamos que ingresan 10,000 mamografías como data de entrenamiento- con el propósito de que la red aprenda a formar gradualmente mejores y mejores características a través de retroalimentaciones sucesivas (“feedback”), por lo general vía una función de error.

Una vez que se ha concluido el entrenamiento y se han obtenido las características, estas son utilizadas por la red neuronal para detectar la presencia de tumores cancerígenos en nuevas mamografías que no hayan sido utilizadas en el proceso de entrenamiento.

Cabe señalar que la metodología de entrenamiento o aprendizaje a la que nos referimos anteriormente se conoce como “Supervised Learning”; en el cual se utiliza un número determinado de mamografías para el proceso de entrenamiento. Existen también otras metodologías que son también importantes denominadas “Self-Supervised Learning”, “Reinforcement Learning” entre otras metodologías. Cabe mencionar también que la red neuronal que acabamos de ver es de una clase de redes neuronales conocidas como Convolutional Neural Networks (ConvNets) que se especializan en tipos de datos euclidianos como lo son las imágenes.

Ahora que tenemos una idea más clara de Deep Learning, veamos a grandes rasgos el concepto de Graph Neural Networks, Geometric Deep Learning, Graph Deep Learning, o cual sea el término utilizado por la comunidad científica.

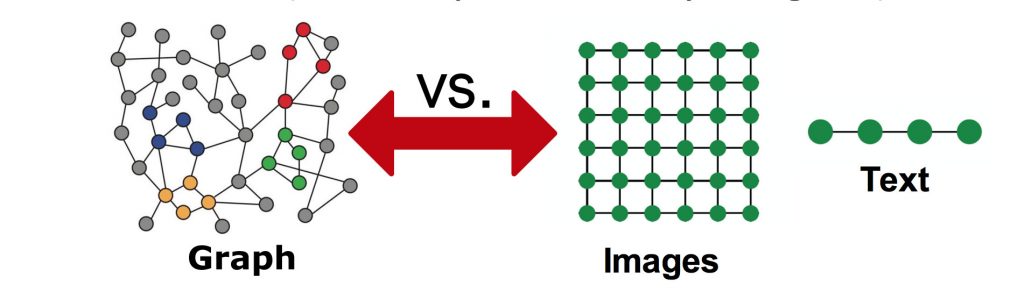

Entre todos los algoritmos de Machine Learning, las investigaciones se ha concentrado esencialmente en Deep Learning, que a su vez gira en torno a un puñado de redes neuronales muy conocidas. Tenemos la red Convolutional Neural Networks (CNNs) que fue desarrollada para el análisis de data euclidiana como las imágenes y, redes como Recurrent Neural Networks (RNNs) y Transformers que fueron desarrolladas para procesar data secuencial como texto y audio, así como también tenemos Graph Neural Networks (GNNs) que fue desarrollado para conjuntos de datos no euclidianos como por ejemplo los grafos.

A diferencia de las imágenes que tienen una clara estructura en forma de cuadricula y, de otros conjuntos de datos como texto y audio que se representan en forma secuencial (estructura lineal); los grafos tienen una estructura irregular.

A pesar de que resulta muy complicado aplicar “Deep Learning” a conjuntos de datos con estructura irregular, entonces la pregunta que surge es por qué el afán de representar los datos en forma de grafos para aplicarles Deep Learning.

Artículo relacionado: “Master of Science in Data Science: A 27 Créditos de Graduarme de CU Boulder“

Antes que veamos las razones del interés que hay en los grafos, es necesario proveer una definición formal de qué exactamente son los grafos.

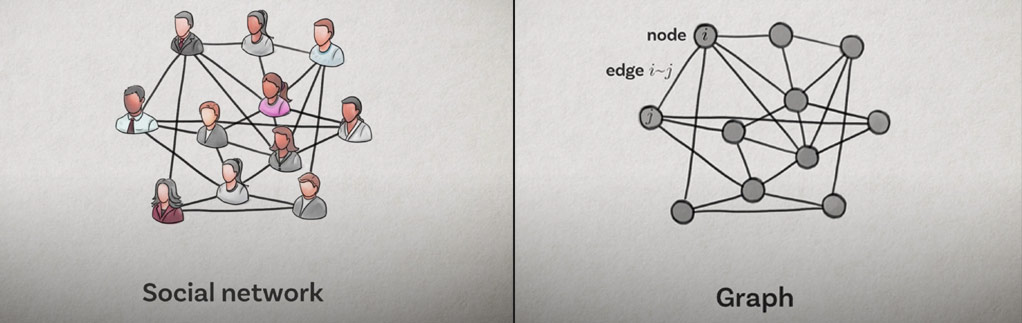

Los grafos son una especie de idioma universal para describir y analizar entidades que se relacionan o interactúan entre si. Son un tipo de estructura de datos abstracto que consiste de nodos (entidades) que están conectados por medio de aristas (relaciones); y que pueden ser usados para modelar prácticamente cualquier cosa.

Probablemente, cada uno de nosotros tiene una idea diferente cuando escuchamos la palabra “grafo”. Por ejemplo, en el área de biología podemos usar nodos para representar proteínas, y usar las aristas para representar diversas interacciones biológicas que ocurren entre ellas. Otro ejemplo bien simple es una red social que modele las relaciones e interacciones entre usuarios donde podemos usar nodos(“nodes”) para representar usuarios, y usar aristas (“edges”) para representar las relaciones o interacciones entre ellos.

Por qué grafos?

Jure Leskovec, profesor del curso “Machine Learning with Graphs” en la Universidad de Stanford, expone que hay muchos tipos de datos y sistemas en diferentes áreas que pueden representarse de manera natural en forma de grafos; y el poder modelar esa estructura relacional que poseen nos permiten construir modelos predictivos mucho más confiables, mejorar el rendimiento del modelo y lograr predicciones mucho más acertadas.

Estas predicciones, afirma Leskovec, pueden ser a nivel de un simple nodo, un par de nodos, un nuevo grafo o por ejemplo la predicción de alguna propiedad de cierta molécula dada.

En el libro “Deep Learning on Graphs” (Yao Ma, Cambridge University Press), se mencionan también otras clases de predicciones como por ejemplo: predecir la calidad del aire (buena, regular, desfavorable), predecir interacciones entre proteínas, recomendar amistades en una red social, etc.

Como se menciona en el libro “Graph Neural Networks: Foundations, Frontiers, and Applications“, si bien las redes GNNs son utilizadas para resolver diversos problemas en distintas áreas, todas ellas consisten de dos pasos importantes: la construcción del grafo y “representation learning“. Cuando nos referimos a la construcción del grafo, nos referimos a representar o transformar los datos de entrada en datos estructurados en forma de grafos.

En resumen, GNNs o Geometric Deep Learning es una sub-área de Deep Learning que es capaz de analizar conjunto de datos no euclidianos, como por ejemplo los grafos, con el propósito de enseñar a las redes neuronales cómo realizar predicciones y clasificaciones.

Y una vez que al modelo neuronal se le ha entrenado, la idea es agarrar un grafo y alimentarlo al modelo; de tal manera que a la salida, el modelo sea capaz de arrojar el resultado deseado.

Espero que este apartado introductorio haya sido de gran utilidad y motivación para aquellos que estén pensando iniciar estudios en el área de “Deep Learning on Graphs”.

Y ya sea que estés investigando un tema específico o simplemente estés comenzando en el área de GNNs, espero que la siguiente compilación de recursos y herramientas sea un buen punto de referencia. En esta compilación podrás encontrar, independientemente de si usas TensorFlow o PyTorch, una gran variedad de librerías si deseas empezar a implementar modelos neuronales que procesen grafos. Así como también encontrarás libros, cursos de las mejores universidades, grupos de lectura de “papers” para estar actualizado, charlas, workshops de conferencias, datasets y benchmarks de gran utilidad si deseas validar tus modelos como por ejemplo Open Graph Benchmark, entre otras herramientas y recursos.

Por último, esta compilación de recursos y herramientas está basado en recomendaciones dadas por Petar Veličković (DeepMind) y por Elvis Saravia (Meta AI). También he incorporado una buena cantidad de otros recursos adicionales que he considerado de suma utilidad provenientes de Telegram, para ser más exactos del “feed” denominado “Graph Machine Learning” el cual es administrado por Sergei Ivanov (Criteo AI Lab).

GraphGPT: Natural Language → Knowledge Graph

GraphGPT convierte lenguaje natural no estructurado en un grafo relacional. [GitHub]

Libros & Proto-Books

- Graph Neural Networks Foundations, Frontiers, and Applications (2022) (Free Download) – Lingfei Wu, Peng Cui, Jian Pei and Liang Zhao.

- Review: “Graph Neural Networks are an emerging machine learning model that is already taking the scientific and industrial world by storm. The time is perfect to get in on the action – and this book is a great resource for newcomers and seasoned practitioners alike! Its chapters are very carefully written by many of the thought leaders at the forefront of the area.” —Petar Veličković (Senior Research Scientist, DeepMind).

- Geometric Deep Learning: Grids, Groups, Graphs, Geodesics, and Gauges (2021) – [Free proto-book] – Michael Bronstein, Joan Bruna, Taco Cohen, Petar Veličković.

- Deep Learning on Graphs (2021) – [Website] [Free preprint] – Yao Ma, Jiliang Tang – Cambridge University Press.

- Machine Learning on Graphs: A Model and Comprehensive Taxonomy (2021) – [Free proto-book] – Ines Chami, Sami Abu-El-Haija, Bryan Perozzi, Christopher Re & Kevin Murphy.

- Graph Representation Learning (2020) – [Website] [Free preprint] – William L. Hamilton, McGill University.

- Graph Neural Networks for Small Graph and Giant Network Representation Learning: An Overview (2019) – [Free proto-book] – Jiawei Zhang.

Tesis de Doctorado

- Modeling Intelligence via Graph Neural Networks – [Tesis] [Slides] – Keyulu Xu, Massachusetts Institute of Technology, MIT.

- The Resurgence of Structure in Deep Neural Networks – [Tesis] – Petar Veličković, University of Cambridge.

- Combinatorial and Neural Graph Vector Representations – [Tesis & Video] – Sergei Ivanov, The Skolkovo Institute of Science and Technology, Skoltech.

- Deep Learning with Graph-Structured Representations – [Tesis] – Thomas Kipf, University of Amsterdam.

Artículos

- 5 Impactful Technologies From the Gartner Emerging Technologies and Trends Impact Radar for 2022 – CDO Trends.

- Emerging Technologies and Trends Impact Radar: 2022 – Gartner.

- You Need To Be Thinking In Knowledge Graphs (2021) – Forbes.

- How Knowledge Graphs Will Transform Data Management And Business (2021) – The Innovator.

- 17 Use Cases for Graph Databases and Graph Analytics (2021) – Oracle.

- Connecting the Dots: Harness the Power of Graphs & ML – Ebru Cucen.

Video Blogs

- 🔥 Geometric Deep Learning – [Video Blog] – Michael Bronstein.

- 🔥 Graph Neural Networks: A Perspective From the Ground Up – [Video Blog] – Alex Foo.

- 🔥 A Series on the Basics of Graph Neural Networks – [Video Blog] – Zak Jost.

Blogs

- What does 2022 hold for Geometric & Graph ML? – [Blog] – Michael Bronstein.

- Graph ML in 2022: Where Are We Now?: Hot trends and major advancements – [Blog] – Michael Galkin.

- 🔥 Geometric Foundations of Deep Learning – [Blog] – Michael Bronstein.

- 🔥 How to Get Started with Graph Machine Learning – [Blog] – Aleksa Gordić.

- Knowledge Graphs in Natural Language Processing @ ACL 2021 – [Blog] – Aleksa Gordić.

- Graph Deep Learning – [Blog] – Towards Data Science.

- Graph Machine Learning – [Blog] – Sergei Ivanov.

- Graph Machine Learning in-Depth: three forms of self-supervised learning – [Blog] – Sergei Ivanov.

- A Gentle Introduction to Graph Neural Networks – [Blog] – Distill.

- Understanding Convolutions on Graphs – [Blog] – Distill.

- 🔥 What is Geometric Deep Learning? – [Blog] – Flawnson Tong

- 🔥 Graph Convolutional Networks – [Blog] – Thomas Kipf.

- Recent Advances in Efficient and Scalable Graph Neural Networks – [Blog] [GitHub] – Chaitanya K. Joshi.

- 🔥 Transformers are Graph Neural Networks – [Blog + Projects + Slides] – Chaitanya K. Joshi.

- 🔥 Benchmarking Graph Neural Networks – [Blog] – Vijay Prakash Dwivedi.

- Math Behind Graph Neural Networks [Blog]

- Graph Machine Learning with Python Part 1: Basics, Metrics, and Algorithms [Blog]

- CUDA-X Accelerated DGL Containers for Large Graph Neural Networks – [Technical Blog] – NVIDIA

Cursos

- Carnegie Mellon University

- Introduction to Graph Neural Network – Carnegie Mellon University’s Deep Learning class (2022) – [Video] [Slides] – Minji Yoon

- 🔥 GDL Course – Geometric Deep Learning: Grids, Groups, Graphs, Geodesics, and Gauges (2021) – Este curso formó parte del programa académico: African Master’s in Machine Intelligence (AMMI 2021) – [Videos & Slides] [Free proto-book] [ICLR 2021 Keynote] [Erlangen Keynote] [Blog] [Website] – Michael Bronstein, Joan Bruna, Taco Cohen & Petar Veličković.

- Stanford University

- 🔥 CS 224W Machine Learning with Graphs (2021) – [Playlist] [Slides] [Projects] [Website]

- CS 520 Knowledge Graphs (KG)

- KG: Data Models, Knowledge Acquisition, Inference and Applications – (2021) – [Videos & Slides] [Playlist]

- KG: How Should AI Explicitly Represent Knowledge? (2020) – [Videos & Slides] [Playlist]

- University of Pennsylvania

- New York University, NYU Center for Data Science

- Speech Recognition and Graph Transformer Networks (2021) – Awni Hannun & Alfredo Canziani

- 🔥 Graph Convolutional Neural Networks (2020) – Xavier Bresson & Alfredo Canziani

- Technical University of Munich, TUM

- McGill University

- Graph Representation Learning (2020) – [Website] [Temas/Papers/Lecturas Recomendadas] – William L. Hamilton

Workshops

- Stanford Graph Learning Workshop (2021) – [Livestream + Videos + Slides] – Stanford University.

- GNNSys – Graph Neural Networks and Systems

- GNNSys 2021 Workshop at MLSys 2021, Conference on Machine Learning and Systems

- Bridge Between Perception and Reasoning: Graph Neural Networks & Beyond (2020) – Workshop at ICML 2020, International Conference on Machine Learning – [Videos] [Accepted Papers] [Best Papers] [Website]

- Graph Machine Learning in Industry (2021) – [Video] [Slides]

- iGDL | Israeli Geometric Deep Learning

- [Video 2021]

- [Video 2020]

- Graph Representation Learning

- Graph Representation Learning and Beyond (GRL+) (2020) – Workshop at ICML 2020, International Conference on Machine Learning – [Livestream + SlidesLive Videos + PDF’s] [Accepted Papers] [Website]

- Graph Representation Learning (2019) – Workshop at NeurIPS 2019, Conference on Neural Information Processing Systems [Accepted Papers] [Slides] [Website]

- Representation Learning on Graphs and Manifolds (2019) Workshop at ICRL 2019, International Conference on Learning Representations – [Accepted Papers] [Website]

- Deep Geometric Learning of Big Data and Applications (2019) – Workshop at IPAM, Institute for Pure & Applied Mathematics (An NSF Math Institute at UCLA) – [Videos + Slides] [Website]

- Graph Mining & Learning – Workshop at NeurIPS 2020, Neural Information Processing Systems Conference – [Videos] [Master Slide Deck]

- Mining and Learning With Graphs (MLG) – Workshop at KDD 2020, Knowledge Discovery and Data Mining Conference – [Videos & Accepted Papers] [Website]

- DLG | Deep Learning on Graphs: Methods and Applications

- DLG 2022 Workshop at AAAI 2022, Conference on Artificial Intelligence

- February 22 – March 1, 2022 [Website]

- DLG 2021 Workshop at KDD 2021, Knowledge Discovery and Data Mining Conference

- [Videos] [Accepted Papers] [Website]

- DLG 2021 Workshop at AAAI 2021, Conference on Artificial Intelligence

- [Videos] [Accepted Papers] [Website]

- DLG 2020 Workshop at KDD 2020, Knowledge Discovery and Data Mining Conference

- DLG 2020 Workshop at AAAI 2020, Conference on Artificial Intelligence

- [Slides] [Accepted Papers] [Website]

- DLG 2019 Workshop at KDD 2019, Knowledge Discovery and Data Mining Conference

- [Slides] [Accepted Papers] [Website]

- DLG 2022 Workshop at AAAI 2022, Conference on Artificial Intelligence

- GCLR | Graphs and More Complex Structures for Learning and Reasoning

- GCLR 2021 Workshop at AAAI 2021, Conference on Artificial Intelligence

- GTRL | Geometrical and Topological Representation Learning

- GTRL 2022 Workshop at ICLR 2022, International Conference on Learning Representations

- Friday, 29 April 2022 [Website]

- GTRL 2021 Workshop at ICLR 2021, International Conference on Learning Representations

- GTRL 2022 Workshop at ICLR 2022, International Conference on Learning Representations

- GLB | Graph Learning Benchmarks

- GLB 2022 Workshop at TheWebConf 2022, The Web Conference

- Apr. 26, 2022 [Website]

- GLB 2021 Workshop at TheWebConf 2021, The Web Conference

- GLB 2022 Workshop at TheWebConf 2022, The Web Conference

- Differential Geometry Meets Deep Learning – Workshop at NeurIPS 2020, Conference on Neural Information Processing Systems [Accepted Papers] [Website]

Tutoriales, Implementaciones & Trucos

- 🔥 Intro to Graph Neural Networks (ML Tech Talks) – [Video] – Petar Veličković

- Introduction to Graph Neural Networks with PyTorch Geometric (beginner-friendly tutorial by Elvis Saravia) – [Notebook]

- 🔥 Graph Neural Networks: Models and Applications – [Website] [YouTube Video] [Free Book] [Slides] – Este tutorial formó parte de la conferencia “AAAI Conference on Artificial Intelligence 2021”

- 🔥 PyTorch Geometric Tutorials (Antonio Longa, Gabriele Santin & Giovanni Pellegrini)

- PyTorch Geometric Tutorial

- [Playlist] [Notebooks & Slides]

- [Video] Invitado especial: Mathias Fey (creador de PyTorch Geometric)

- [Video] Invitado especial: Sergei Ivanov (Criteo AI Lab)

- Advanced PyTorch Geometric Tutorial

- PyTorch Geometric Tutorial

- Graph4NLP Deep Learning on Graphs for Natural Language Processing – [Website]

- Graph4NLP 2022 Tutorial at AAAI’22, Conference on Artificial Intelligence.

- Graph4NLP 2021 Tutorial at NAACL’21, North American Chapter of the Association for Computational Linguistics.

- Graph4NLP 2021 Tutorial at ACM SIGIR’21, Conference of the Association for Computing Machinery Special Interest Group in Information Retrieval.

- Graph4NLP 2021 Tutorial at IJCAI’21, International Joint Conference on Artificial Intelligence.

- [Video]

- Graph Neural Networks (Hands-on) [Playlist]

- Bag of Tricks for Node Classification with Graph Neural Networks – Yangkun Wang et al – [Paper] [Code] – Premiado como el “Best Paper” en el workshop “Deep Learning on Graphs” llevado a cabo en la conferencia KDD 2021.

- Efficient Graph Generation with Graph Recurrent Attention Networks – [Paper] [Code] – Renjie Liao et al.

- Summer School on Geometric Deep Learning – [Videos + Slides + Exercises] [Posters] [Website] – Technical University of Denmark, University of Copenhagen, Aalborg University.

- Deep Learning on Graphs (a Tutorial) – [Website]

Librerías

- PyG PyTorch Geometric – [Documentation] [Notebooks & Video Tutorials] [Learn PyG by Examples] [GitHub]

- DGL Deep Graph Library (PyTorch/TensorFlow) – [Documentation] [Notebooks & Tutorials] [Learn DGL by Examples] [GitHub] [Website]

- Graph4NLP Deep Learning on Graphs for Natural Language Processing (PyTorch/TensorFlow) – [Website] [Documentation] [Video Tutorials & Slides] [GitHub]

- BrainGB: A Benchmark for Brain Network Analysis with Graph Neural Networks – [Website] [Paper] [GitHub]

- TensorFlow GNN – [Blog] [GitHub]

- GNNkeras: A Keras-based library for Graph Neural Networks and homogeneous and heterogeneous graph processing [Paper] [GitHub]

- Dive into Graphs – [Documentation] [GitHub]

- PyTorch Geometric Temporal – [Documentation] [GitHub]

- Graph Nets (Tensorflow/Sonnet) – [GitHub]

- Spektral (TensorFlow/Keras) – [Documentation] [GitHub]

- Jraph (Jax)- [Documentation] [GitHub]

Proyectos

- Stanford Network Analysis Project – [Website] [Projetcs] [Large Network Datasets] [Biomedical Network Datasets]

- Graph Deep Learning Lab – [Projects + Codes] – Xavier Bresson, School of Computing, Dept of Computer Science, National University of Singapore.

Benchmarks & Datasets

- Open Graph Benchmark: Benchmark Datasets, Data Loaders and Evaluators for Graph Machine Learning [Website] [Team]

- Datasets for Machine Learning on Graphs [Paper] [Datasets & Code]

- Large-Scale Graph ML Datasets – [Datasets & Code]

- BrainGB: A Benchmark for Brain Network Analysis with Graph Neural Networks – [Website] [Paper] [GitHub]

- Benchmarking Graph Neural Networks – [Datasets & Code] [Blog] [Paper]

- Wiki-CS: A Wikipedia-Based Benchmark for Graph Neural Networks – [Paper] [Dataset & Implementation] – [Video] – Péter Mernyei & Cătălina Cangea.

- Datasets adicionales

- Benchmarks adicionales

Arquitecturas (GNNs)

- LSPE: Graph Neural Networks with Learnable Structural and Positional Representations – [Video 1] [Video 2] [Code & Dataset] [Paper] – Vijay Dwivedi, Anh Tuan Luu, Thomas Laurent, Yoshua Bengio & Xavier Bresson. Accepted at ICLR 2022.

- 🔥 GraphSAGE: Inductive Representation Learning on Large Graphs – [Website + Code + Dataset] [Paper] – William L. Hamilton, Rex Ying & Jure Leskovec. Accepted at NeurIPS 2017.

- EQUIBIND: Geometric Deep Learning for Drug Binding Structure Prediction [Code & Dataset] [Paper] – Hannes Stärk, Octavian-Eugen Ganea, Lagnajit Pattanaik, Regina Barzilay & Tommi Jaakkola.

- Arquitecturas adicionales.

Publicaciones & Survey Papers

- Graph Neural Networks Designed for Different Graph Types: A Survey (2022) – [Paper]

- Self-Supervised Learning of Graph Neural Networks: A Unified Review (2022) – [Paper]

- MolGenSurvey: A Systematic Survey in Machine Learning Models for Molecule Design (2022) [Paper]

- Graph Neural Networks in IoT: A Survey (2022) [Paper]

- Graph Neural Networks are Dynamic Programmers (2022) [Paper]

- Graph Neural Networks in Particle Physics: Implementations, Innovations, and Challenges [Paper]

- Graph Neural Networks for Natural Language Processing: A Survey [2021] – [Paper] – Lingfei Wu et al.

- Combinatorial Optimization and Reasoning with Graph Neural Networks (2021) – [Paper] – Quentin Cappart et al. IJCAI 2021 International Joint Conference on Artificial Intelligence.

- 🔥 Graph Neural Networks: A Review of Methods and Applications (2021) – [Paper] – Jie Zhou et al.

- Foundations and Modelling of Dynamic Networks Using Dynamic Graph Neural Networks: A survey (2021) – [Paper] – Joakim Skarding et al.

- 🔥 Deep Graph Infomax – [Paper] [Code] – Petar Veličković, William Fedus, William L. Hamilton, Pietro Liò, Yoshua Bengio, R Devon Hjelm.

- 🔥 How Powerful are Graph Neural Networks? (2019) – [Paper] [Related Video 1] [Related Video 2] – Keyulu Xu, Weihua Hu, Jure Leskovec & Stefanie Jegelka.

- 🔥 A Comprehensive Survey on Graph Neural Networks (2019) – [Paper] – Zonghan Wu et al.

- Graph Attention Networks (2018) – [Website] [Paper] – Petar Veličković, Guillem Cucurull, Arantxa Casanova, Adriana Romero, Pietro Liò & Yoshua Bengio.

- Geometric Deep Learning: Going Beyond Euclidean Data (2017) – [Paper] – Michael M. Bronstein, Joan Bruna, Yann LeCun, Arthur Szlam, Pierre Vandergheynst.

- Gated Graph Sequence Neural Networks – [Paper] [Slides] [Poster] [Code] [Video] – Microsoft Research. ICLR 2016 International Conference on Learning Representations.

Graph Machine Learning y sus Aplicaciones

- Multiagent off-screen behavior prediction in football (2022) [Paper]

- How AWS uses graph neural networks to meet customer needs (2022) [Blog]

- Forecasting Global Weather with Graph Neural Networks (2022) [Paper]

- 3D Human Pose Estimation Using Möbius Graph Convolutional Networks [Paper]

- Deep Reinforcement Learning Guided Graph Neural Networks for Brain Network Analysis [Paper]

- Graph Representation Learning in Biomedicine (2021) – [PDF] – Michelle M. Li et al.

- Utilising Graph Machine Learning within Drug Discovery and Development (2021) – [PDF] – Thomas Gaudelet et al.

- Graph Neural Networks: Methods, Applications, and Opportunities (2021) – [PDF] – Lilapati Waikhom, Ripon Patgiri.

- Traffic Prediction with Advanced Graph Neural Networks (2020) – [Blog] – DeepMind.

- Food Discovery with Uber Eats: Using Graph Learning to Power Recommendations (2019) – [Blog] – Uber Engineering.

- AliGraph: A Comprehensive Graph Neural Network Platform (2019) – [Paper]

- 🔥 Representation Learning on Graphs: Methods and Applications (2018) – [PDF]- William L. Hamilton, Rex Ying, Jure Leskovec.

- 🔥PinSage: A New Graph Convolutional Neural Network for Web-Scale Recommender Systems (2018) – [Blog] [Paper]

- 🔥 Graph Signal Processing: Overview, Challenges and Applications (2018) – [PDF] – Antonio Ortega et al.

Papers Aceptados en Conferencias

Lista de “papers” acerca de Graph Machine Learning aceptados en las mejores conferencias en Inteligencia Artificial.

- CVPR – Conference on Computer Vision and Pattern Recognition – [2021] [2020]

- ICCV – International Conference on Computer Vision – [2021]

- ECCV – European Conference on Computer Vision – [2020]

- NeurIPS – Conference on Neural Information Processing Systems – [2021] [2020]

- ICML – International Conference on Machine Learning – [2021] [2020]

- ICLR – International Conference on Learning Representations – [2022] [2021] [2020]

- AAAI – AAAI Conference on Artificial Intelligence – [2022] [2021] [2020]

- IJCAI – International Joint Conference on Artificial Intelligence – [2021] [2020]

- TheWebConf – The Web Conference – [2021]

- KDD – Knowledge Discovery and Data Mining Conference – [2021] [2020]

- IEEE ICDM – IEEE International Conference on Data Mining – [2021] [2020]

- WSDM – International Conference on Web Search and Data Mining [2022] [2021]

- ACL – Association for Computational Linguistics [2021] [2020]

- EMNLP – Conference on Empirical Methods in Natural Language Processing [2021] [2020]

- NAACL – North American Chapter of the Association for Computational Linguistics [2021]

Feeds

Grupos

- Graph Representation Learning Reading Group – [Papers & Videos] – Group at Mila, Quebec AI Institute – Michael Galkin, Ladislav Rampášek & Christopher Morris.

- The Learning on Graphs and Geometry Reading Group – [Papers, Videos & Slides] – Hannes Stärk

- Graph Neural Networks User Group [Videos] – Organizado por un grupo de profesionales de Amazon AI y NVIDIA.

Newsletters

- Progress in Graph Neural Networks (Nov. 2021) – [Newsletter #19] – El boletín informativo #19 de “Papers with Code” destacó los adelantos, aplicaciones y el progreso realizado en el área de Graph Neural Networks.

Charlas

- Geometric Deep Learning (2022) – [Video] – Geordie Williamson – Recomendado para todos aquellos interesados en el aspecto matemático de GDL.

- Theoretical Foundations of Graph Neural Networks (2021) – [Video] [Slides] – Petar Veličković – Esta charla es parte de la serie de seminarios “Wednesday Seminars“, Department of Computer Science and Technology, University of Cambridge.

- 🔥 Geometric Deep Learning Blueprint (Special Edition 2021) – [Video] – Michael Bronstein, Joan Bruna, Taco Cohen & Petar Veličković.

- London Geometry and Machine Learning LOGML Summer School (2021) – [Videos] [Projects] [Website]

- Exploring Complexity – How Graph Data Science is Pushing New Boundaries (2021) – [Video].

- 🔥 Deep Learning on Graphs: Successes, Challenges (2020)- [Video] – Michael Bronstein.

- Machine Learning y Grafos (2020) – [Video] – Federico Albanese.

- 🔥 Graph Nets: The Next Generation (2020) – [Video] – Max Welling – Esta charla forma parte de la serie de seminarios “Seminar on Theoretical Machine Learning” del instituto “Institute for Advanced Study” (IAS).

- 🔥 Representational Power of Graph Neural Networks – Stefanie Jegelka

- [Video] NeurIPS 2019 – Conference on Neural Information Processing Systems

- [Video] Workshop on Theory of Deep Learning: Where next? Institute for Advanced Study

- [Related Paper] How Powerful are Graph Neural Networks?

Alguna otra cosa que falte? Siéntanse con plena libertad de aportar u opinar en la sección de comentarios. Espero que toda esta información les sea de gran utilidad y suerte en el aprendizaje!

Very good article. Mr. Homer Diaz shines light to the importance of GNN in today’s technological world.